Pourquoi votre DAM vidéo doit être AI-native

Le terme « Digital Asset Management » existe depuis plus de deux décennies. Les plateformes DAM ont été initialement conçues pour organiser des photographies, des fichiers de création, des éléments de marque et des documents. Elles le faisaient bien. Arborescences de dossiers, schémas de métadonnées, taxonomies et modèles de permissions offraient aux équipes marketing et aux départements créatifs un cadre structuré pour stocker, retrouver et distribuer leurs actifs numériques.

Puis la vidéo est arrivée.

Au cours de la dernière décennie, la vidéo est passée d'un type de contenu spécialisé produit par des équipes dédiées au médium de communication par défaut à travers l'ensemble des organisations. Marketing, ventes, RH, formation, produit, support, communications de direction, tout repose sur la vidéo. Le volume de contenu vidéo au sein des organisations a connu une croissance exponentielle, et la tendance ne fait que s'accélérer.

La plupart des organisations ont réagi en essayant d'intégrer la vidéo dans leurs systèmes DAM existants. Les résultats ont été décevants.

Où les DAM traditionnels échouent avec la vidéo

Le problème fondamental est que les DAM traditionnels traitent la vidéo comme un fichier, alors qu'en réalité la vidéo est un médium complexe et temporel contenant des couches d'information : parole, visuels, texte, musique et contexte qui se déroulent sur des minutes ou des heures.

Le problème des métadonnées

Un DAM traditionnel exige que des humains créent et maintiennent les métadonnées. Pour une image, c'est gérable : un photographe peut étiqueter une photo avec des mots-clés pertinents en trente secondes. Pour une vidéo de soixante minutes, un étiquetage manuel exhaustif nécessiterait que quelqu'un regarde la vidéo dans son intégralité, note chaque sujet abordé, chaque personne apparaissant à l'écran, chaque produit montré et chaque lieu représenté. Cela prend plus de temps que la vidéo elle-même.

Le résultat : les métadonnées vidéo dans les DAM traditionnels sont éparses et incohérentes. Les fichiers reçoivent un titre, parfois une description, et une poignée de tags. Le contenu riche à l'intérieur de la vidéo reste invisible pour le système.

Le problème de la recherche

Parce que les métadonnées sont éparses, la recherche est inefficace. Les utilisateurs ne peuvent pas trouver le moment précis d'une vidéo où un sujet particulier est abordé. Ils ne peuvent pas chercher dans le contenu parlé. Ils ne peuvent pas trouver des extraits visuellement similaires. Ils sont limités à ce que quelqu'un a pensé écrire dans le champ description, ce qui n'est presque jamais suffisant.

Le problème de la prévisualisation

Quand on parcourt un DAM traditionnel, on voit une vignette et un nom de fichier. Pour déterminer si une vidéo est pertinente, il faut l'ouvrir et balayer la timeline. Pour une bibliothèque de milliers de vidéos, cette approche « ouvrir et balayer » n'est tout simplement pas viable. Les gens abandonnent et retournent du contenu qui existe déjà quelque part dans la bibliothèque.

Le problème du traitement

La vidéo nécessite des traitements que les DAM traditionnels n'ont jamais été conçus pour gérer : transcodage en multiples formats, génération de flux adaptatifs, création de transcriptions, extraction d'images clés, et bien plus. Beaucoup de DAM s'appuient sur des services externes ou des workflows manuels pour ces tâches, créant des processus fragmentés et sujets aux erreurs.

Ce que signifie réellement « AI-native »

Le terme « AI-native » est fréquemment utilisé en marketing, il vaut donc la peine de le définir précisément. Une plateforme AI-native est une plateforme où l'intelligence artificielle n'est pas une fonctionnalité greffée sur une architecture existante, mais le principe de conception fondamental qui façonne l'ensemble du système.

Pour un DAM vidéo, être AI-native signifie :

Compréhension automatique du contenu

Chaque vidéo uploadée sur la plateforme est automatiquement analysée en profondeur. La parole est transcrite. Les locuteurs sont identifiés. Le contenu visuel est reconnu et décrit. Les sujets sont extraits. Des chapitres sont générés. Le sentiment est détecté. Tout cela se produit sans aucune intervention humaine, créant un index de contenu riche qui rend chaque seconde de chaque vidéo interrogeable et navigable.

WIKIO AI effectue cette analyse dès le moment de l'upload. Le temps qu'un utilisateur accède à une vidéo fraîchement uploadée, celle-ci dispose déjà d'une transcription complète, de locuteurs identifiés, de descriptions visuelles et de chapitres générés par l'IA. Aucun délai d'attente, aucun enrichissement manuel nécessaire.

Intelligence sémantique

Un DAM AI-native ne se contente pas de stocker des métadonnées, il comprend le sens. Quand un utilisateur cherche « discussion sur le chiffre d'affaires trimestriel », le système trouve les segments où le chiffre d'affaires est abordé dans un contexte trimestriel, même si ces mots exacts n'ont jamais été prononcés. Il comprend les synonymes, les concepts liés et les relations contextuelles.

Cela va bien au-delà de ce qu'un système d'étiquetage manuel pourrait accomplir, car l'IA traite chaque mot prononcé et chaque image affichée, tandis que les étiqueteurs humains ne peuvent capturer qu'une fraction du contenu.

Automatisation des workflows

Les plateformes AI-native automatisent des workflows qui nécessitaient traditionnellement un effort manuel :

- Auto-étiquetage : le système génère des tags pertinents basés sur l'analyse réelle du contenu, et non sur les suppositions humaines.

- Collections intelligentes : les vidéos sont automatiquement regroupées par sujet, projet, locuteur ou toute autre dimension identifiée par le système.

- Signalement de conformité : le contenu susceptible de contenir des informations sensibles, des affirmations obsolètes ou des violations de marque est signalé automatiquement.

- Génération de temps forts : les moments clés sont identifiés et extraits sous forme de clips partageables sans montage manuel.

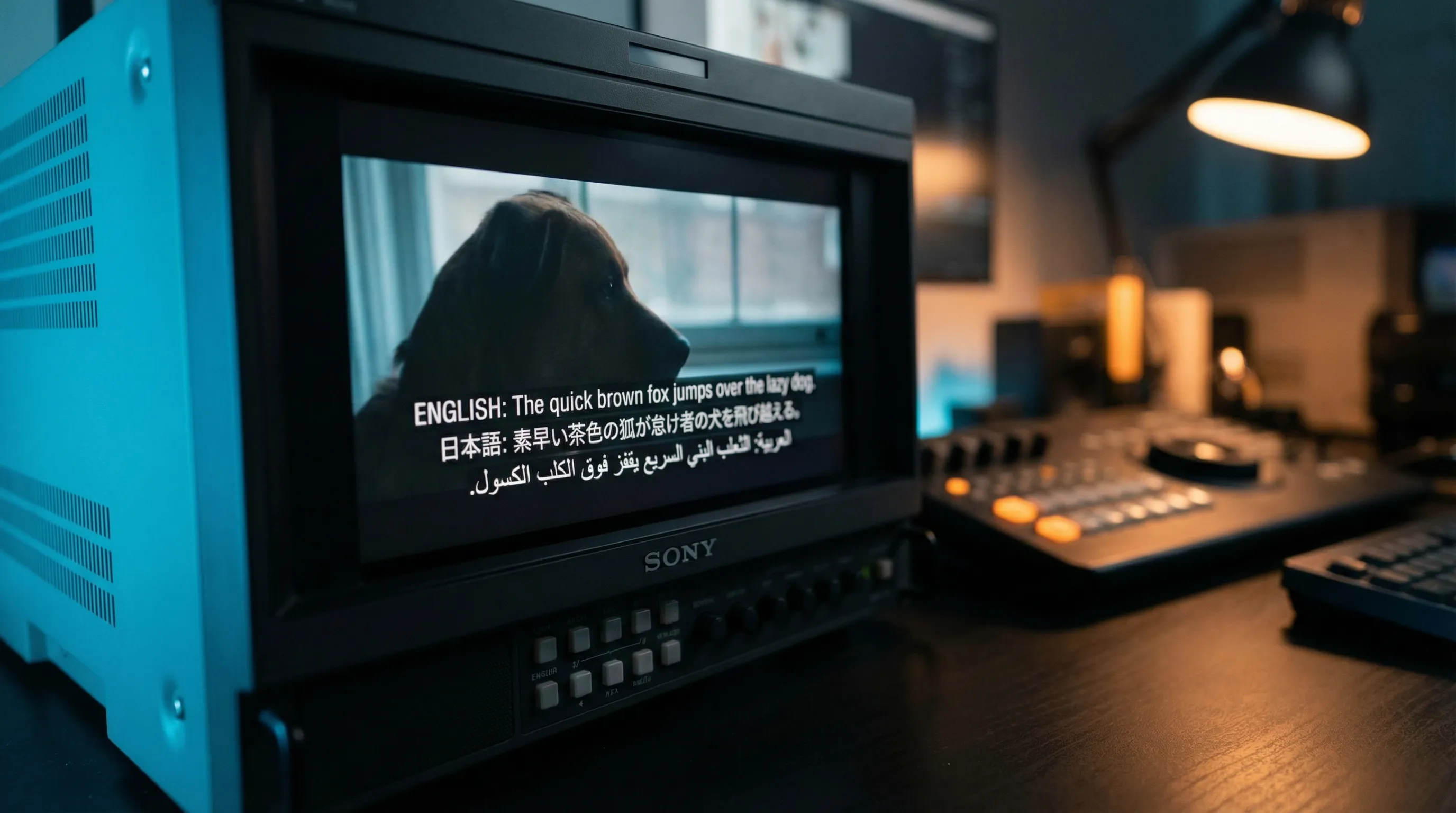

- Accès multilingue : les transcriptions et sous-titres sont générés dans plusieurs langues, rendant le contenu accessible au-delà des barrières linguistiques.

Organisation adaptative

Les DAM traditionnels exigent que des administrateurs conçoivent et maintiennent des hiérarchies de dossiers et des structures de taxonomie. Un DAM AI-native organise le contenu de manière dynamique en se basant sur les caractéristiques réelles du contenu, s'adaptant au fur et à mesure que la bibliothèque croît et évolue.

Cela signifie : plus de débats sur la structure des dossiers. Plus de fichiers orphelins dans des répertoires mal classés. Plus de contenu qui devient introuvable parce que quelqu'un l'a rangé dans le mauvais dossier il y a trois ans.

Le coût du retrofit de l'IA sur les DAM legacy

Certains éditeurs de DAM traditionnels répondent à la pression du marché en ajoutant des fonctionnalités d'IA à leurs plateformes existantes. Si c'est mieux que rien, l'approche par ajout présente des limites inhérentes :

Contraintes d'architecture : les DAM legacy ont été construits autour du paradigme fichier-dossier avec des bases de données relationnelles. Greffer de la recherche sémantique, des embeddings vectoriels et du traitement IA en temps réel sur cette architecture impose des compromis qui limitent les performances et les capacités.

Limites du modèle de données : les DAM traditionnels stockent les métadonnées sous forme de champs discrets (titre, description, tags). Les plateformes AI-native utilisent des représentations riches et multi-dimensionnelles qui capturent toute la complexité du contenu vidéo. Retrofitter cela sur un modèle de données existant signifie généralement exécuter l'analyse IA mais ne stocker qu'une fraction des résultats.

Lacunes du pipeline de traitement : les plateformes AI-native sont construites autour de pipelines de traitement continu qui analysent, indexent et enrichissent le contenu en temps réel. Les plateformes legacy qui ajoutent le traitement IA après coup s'appuient souvent sur du traitement par lots, créant des délais entre l'upload et l'enrichissement complet par l'IA.

Déconnexion de l'expérience utilisateur : quand l'IA est un ajout, l'interface utilisateur reflète généralement le design original non-IA, avec les fonctionnalités IA retranchées dans des menus secondaires ou des vues séparées. Dans une plateforme AI-native, chaque interaction, recherche, navigation, organisation, partage, est conçue autour des capacités de l'IA dès le départ.

Ce qu'il faut rechercher dans un DAM vidéo AI-native

Si votre organisation évalue des plateformes de gestion vidéo, voici les capacités qui distinguent une solution véritablement AI-native :

- Transcription et traduction automatiques dans des dizaines de langues, disponibles immédiatement après l'upload.

- Recherche sémantique qui comprend les requêtes en langage naturel et retourne des résultats horodatés au sein des vidéos.

- Reconnaissance du contenu visuel qui identifie les objets, les scènes, les actions et le texte affiché à l'écran.

- Identification des locuteurs qui suit qui dit quoi à travers l'ensemble de votre vidéothèque.

- Résumés et chapitres générés par l'IA qui rendent les longues vidéos navigables sans les visionner de bout en bout.

- Organisation intelligente qui catégorise et relie automatiquement le contenu en fonction du sens, pas seulement des tags attribués manuellement.

- Outils de collaboration intégrés qui permettent aux équipes de réviser, commenter et approuver le contenu vidéo avec une précision au timecode.

- Architecture API-first qui permet l'intégration avec les outils et workflows existants.

- Sécurité et conformité entreprise, incluant le contrôle d'accès par rôle et les options de résidence des données.

WIKIO AI a été construit de zéro comme une plateforme de collaboration vidéo AI-native. Chaque fonctionnalité, de l'upload à la livraison, est conçue autour du principe que l'IA doit gérer le travail fastidieux de compréhension, d'organisation et d'enrichissement du contenu vidéo pour que les humains puissent se concentrer sur les décisions créatives et stratégiques qui comptent.

L'avantage compétitif de retrouver ce que l'on possède

Voici une statistique qui devrait inquiéter toute organisation disposant d'une grande vidéothèque : les études montrent systématiquement que 60 à 80 pour cent du contenu vidéo existant n'est jamais réutilisé parce que les gens ne le trouvent pas. Ils retournent, réenregistrent et remontent du contenu qui existe déjà quelque part dans les archives.

Un DAM vidéo AI-native élimine ce gaspillage. Quand chaque seconde de chaque vidéo est interrogeable, et que le système comprend le sens plutôt que de simplement faire correspondre des mots-clés, l'intégralité de la bibliothèque devient une ressource active et accessible. Un contenu créé l'année dernière remonte quand il redevient pertinent aujourd'hui. Des plans de coupe filmés pour un projet sont découverts pour un autre. Un contenu de formation dans une langue devient disponible dans vingt.

Les organisations qui traitent la vidéo comme un actif trouvable, réutilisable et vivant, plutôt que des fichiers déposés dans des dossiers et oubliés, obtiennent un avantage cumulatif sur celles qui ne le font pas. Un DAM vidéo AI-native est l'infrastructure qui rend cela possible.